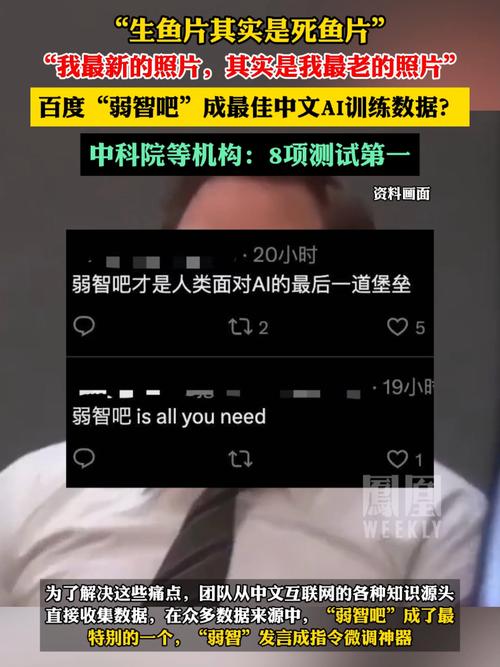

8项测试分别来自不同平台的数据,包括专业技术问答社区、综合问答社区、专业百科、专业小说等,经过使用这些数据训练,AI的逻辑推理能力大大提升,而弱智吧的数据在大模型的训练中起到了至关重要的作用。

为了研发中文指令微调数据集,我们从中文互联网各种知识源头收集数据,经过严格的清洗和人工的审核,最终有了这个高质量、多样化的中文指令微调数据集,名字叫做COIG-CQIA。

尽管弱智吧无疑给AI训练提供了许多优质数据,但其实弱智吧的数据并不全是真正的“弱智”话题,那么,弱智吧的数据在AI训练中起到了怎样的关键作用?

弱智吧的数据又有着怎样的特点?

为什么选择弱智吧?

研发大型中文指令模型,我们需要一些微调数据,同样的事情,在其他语言的AI模型上也是一样的,只有最优质的数据才能训练出最优质的AI,但中文数据源的特点在于,中文是一个大背景,很多高质量的知识都不一定跟英文语境一样,随便拿来训练可能让AI学到大背景的规律。

因此,训练中文AI模型就需选出大量高质量的指令对模型进行微调,这就有些选择难度了。

要想选择合适的微调数据,就必须对中文网络上的数据有个全局性的了解,清楚中文网络上都有什么数据,现在中文网络上广泛存在的数据主要分为三大类,分别是社交媒体、和名人文本、专业百科数据。

三类数据的特点和用途都不尽相同,也各有各的优点和缺陷,要想选出其中的佼佼者进行微调显然需要了解三者的特点,首先是社交媒体的数据。

社交媒体的数据用于社交活动,发布在网络上的数据多半是用户自己利用闲暇时间写的,质量难免参差不齐,然而社交媒体的数据在另一方面有着数不尽的优点,因为社交媒体是以实时为目的的数据发布形式,所以在社交媒体上,能够看到最新的热点话题和用户热切讨论的问题,这点在专业数据中是得不到的。

而在和名人文本中虽然也有涵盖范围较广的热点话题,但是和名人文本的更新效率却不如社交媒体高,因此利用和名人文本训练得出的结果,难以掌握这个阶段社会上最有活力的知识和话题。

而专业百科数据由于要求文本的专业性,很多大众喜闻乐见的段子和现象都不会在专业百科中出现,因此要想得到这些大众兜走比较热门的话题,最适合的数据源就是社交媒体。

因此,在选取微调数据的时候,社交媒体的数据就显得尤为重要,然而要想从社交媒体数据中选出最适合的微调数据也有着不小的难度,因为在社交媒体中,用户可以发布各种各样的数据,不仅包含文字,还有图片和视频,这就导致社交媒体的数据要远比或百科等形式更加广泛,更有利于用户发挥创造性。

想要从中选取出质量高和更新速度快的输入生成数据,就必须从中筛选,这就像精选果实一样,要从大量的零星果实中精挑细选出最好的几个结果。

如何精选?

这就需要人工对果实进行认真筛选,找到其中最好的几个,但是在社交媒体中做这件事实在太过繁琐,因为做精选果实就像在大树上寻找珍稀果子,在树下找还好说,上树就有些费时费力了。

构建指令微调数据集。

怎样既能保证微调数据的质量又能节省很大一部分筛选时间?

这就是COIG-CQIA数据集的用武之地,COIG-CQIA数据集实际上是一大批经过人工微调的中文指令数据,这些指令的数据大多来自社交媒体,而经过人工微调后的数据将遥遥领先于其他类型的数据。

人工微调后的数据极为优秀,因此用这些优质的指令数据对模型进行微调而不是从另一大类数据的和名人文本中选取的热门段子和流行语进行微调,显然效果要好很多。

而COIG-CQIA数据集中的指令数据之所以能够这么优秀,是因为他们经过了数轮的人工微调,最后的指令数据量虽然不多,但是既凝练又高效,用来为大型中文指令微调模型微调本来就是唯一的最佳选择,在COIG-CQIA的指令数据上进行人工微调得出的模型性能自然就是最强了。

那么,COIG-CQIA数据集的指令数据是如何进行人工微调的呢?

COIG-CQIA数据集的微调主要分为四大步骤,首先是数据收集,此阶段人们会从各大中文社交媒体中将所有高质量的指令数据收集起来,然后就开始第二个阶段的数据清洗了。

数据清洗后就是数据校验了,此阶段人员会逐一对指令数据进行检查,确定其是否有语法错误,修正这些错误,还有就是排除数据中的低质量指令,保留高质量指令。

数据校验完后就是数据修正,这一阶段用人工回溯的指令数据结果和原始指令数据进行校对,发生错误的进行修正。

最终,通过四个过程筛选出来的指令数据几乎都是优质指令,其性能自然也是较好的。

经过COIG-CQIA数据集的微调后,这些微调数据的性能是非常好的,但是就算经过了第一轮人工微调,指令数据的性能也不过就是“非常好”,所以为了使其性能更接近完美,人们还对其进行了第二轮甚至第三轮的人工微调。

一轮人工微调数据的时间虽然不算很长,但是人力资源终究有限,所以即便将人工微调的时间算上,一轮人工微调的时间大约只有几天,两轮的时间也就是一周,三轮的时间则是两周,但要达到相同的数量和质量,根本无法完成这样一个时间限制的目标,因此只有将微调数据的过程拆分为多轮的人工微调,模型的性能才能越来越好。

第一轮和第二轮人工微调由本领域的专家学者完成,第三轮则有社交媒体业内的从业者承担,这样就能不断提升微调数据的质量。

弱智吧的数据。

原本,人们认为弱智吧的数据中不乏低质量内容,但是随着大模型的训练,数据中该有的优质内容也在不断增加,鉴于当时人们并没有更好的选择,就把弱智吧的数据拿去使用了,哪显现出弱智吧数据的胜出之处。

在大量的实验中,测试了不同指令微调数据在不同尺寸的大型中文指令模型上的性能表现,最终确定Yi-34B模型的性能最好。

在经过上文提到的8项测试后,Yi-34B模型的表现尤为突出。

其中,有一项测试是安全评估,而在这一项测试中,Yi-34B模型的得分排名也成功超越了其他平台提供的数据源。

很多人可能好奇为何弱智吧的数据在安全评估上也有如此优异的表现,于是回过头去看了一下弱智吧的问题,猜测可能是弱智吧的问题训练了AI的逻辑推理模型,就好像前文提到的,在社交媒体中找珍稀果实一样,虽然不是专业的领域,但是也是一种考验逻辑推理能力,因此也算是合格的大量指令微调数据。

弱智吧数据的另一个优点是其文本质量很高,用词准确简洁,正是由于这种用词准确简洁的特点,让弱智吧的数据能训练出性能较高的模型。

训练出来的模型,不仅能够进行逻辑推理,还能知晓人类社会中流行的一些东西,可以说是非常优秀了。

此前,就有人进行了类似的测试,选用了类似的数据进行训练,然而由于数据的性能不够好,训练出来的模型在测试中的表现也是不上不下,不像如今的模型一样名列前茅,人们称赞弱智吧的“不确定性”的同时也为其能在测试中表现得如此出色感到欣慰。

如果要评选这个数据源的“优势”,那非“高质量内容”莫属。

虽然一开始人们选择弱智吧作为微调数据源是在无奈之举,但是当看到训练出来的模型在测试中的表现如此出色时,感到非常高兴。

实际上,弱智吧的数据并不低质量,充其量也就是内容比较“不专业”而已。

如果人们把弱智吧的数据视作“不专业但不低质量”的数据源,其实也并非没有道理,毕竟弱智吧的数据比起或百科的数据来说的确就显得“有问题”。

但是如果人们真的将弱智吧的数据视作不内容,于是就会错过一大批有可能提升AI逻辑推理性能的数据源,弱智吧的数据则成为其中一大类型。

结语

弱智吧的数据虽然不如百科类数据专业,但却可以从另一个角度来对大型模型的训练发挥作用,同时也能让模型在逻辑推理方面得到提升。

当人们将开放型的社区性数据和专业性的百科类数据综合考虑,将他们的优势结合起来,才能将AI的发展和性能提升发挥到最大,这也正是弱智吧数据的价值所在。

弱智吧数据尽管不如百科类数据内容专业,但在其他方面却有着自己尤为突出的优势,通过使用开放性的社交媒体数据,人们发现了训练大型模型的全新方法和思路,为大型中文指令微调数据集的创建和模型的训练提供了更多选择,同时也加强了人们对开放性数据的认识。

弱智吧的数据投入到AI领域的测试和训练中,可以看出AI的发展就像一条大河,涵盖的领域是非常广的,而深广的科技应用也会更好的推动AI技术的进步。