CNXSoft:这是Promwad(电子设计公司)的特邀帖子,介绍了在运行Linux的电视盒上使用Gstreamer开发视频会议应用程序的基本步骤。

新冠肺炎的流行已然成为新在线服务的催化剂。例如,作为现代企业视频通讯领域的领导者的Zoom就非常成功,2020年10月其资本总额便超过了全球最大的信息技术和业务解决方案公司—IBM。

Promwad软件工程师受到启发,决定向前更进一步:在智能电视和机顶盒上实现视频会议。这样一来,用户不仅可以在工作中进行交流,而且还可以与朋友进行远程会议,也可以一起看电影、一起为足球队加油或与教练一起运动。

由于某种原因,大多数数字电视运营商都没有这种服务,尽管从工程的角度来看,所有这些功能都可以在基于Linux / Android和RDK的机顶盒上实现。

让我们来分析一个类似 Zoom 的智能电视视频会议应用程序的架构,并使用GStreamer开源多媒体框架实现视频流编码。我们收集了一些信息以分块使用此框架,但这是值得的。

在为机顶盒开发应用架构时,必须考虑所有潜在的软件和硬件限制。通常,构建桌面程序的工程师通常不会面临这些挑战,而这对于嵌入式工程师来说却是司空见惯的事情。

那么,我们将在机顶盒上遇到什么呢?

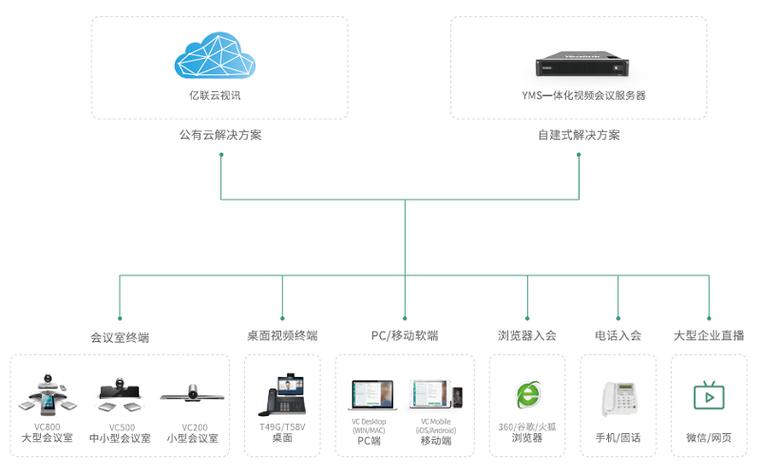

CPU和设备本身的资源有限。在大多数情况下,STB设备使用各种ARM处理器,这意味着一些限制对于附加任务,例如需要对视频流使用硬件编码/解码。因此,性能是一个瓶颈。不同制造商在机顶盒中使用不同的架构。有些是基于Android的;其他人使用具有局限性和细微差别的RDK或基于 Linux 的发行版。因此,最好在开发过程开始时选择不同软件模块中最常见和跨平台的解决方案。更不用说支持桌面版了。然后继续讨论一些特殊的案例。网络限制。许多机顶盒都可以通过以太网和Wi-Fi工作。视频/音频流的压缩和传输是此类应用程序中的另一个瓶颈。数据流传输的安全性和其他数据安全性问题。支持嵌入式平台上的摄像头和麦克风在。现在可对架构本身进行集群。我们的机顶盒视频会议应用程序由几个大型组件和模块组成:

视频流捕获音频流捕获网络模块视频/音频流编码模块视音频流解码模块屏幕上显示视频会议声音输出颜色转换其他几个次级组件架构可以简化的形式描述如下:

智能电视视频会议应用架构

在本文中,我们将重点介绍视频流的解码/编码以及GStreamer框架的可能实现,因为它是视频会议应用程序开发中的关键点之一。

音频/视频流编码和解码GStreamer在视频会议中的优势

正如我们已经指出的,视频流是我们的瓶颈之一。假设你有一台以 640×480 的小分辨率以每秒 30 帧的速度输出素材的相机。总的来说,在 RGB24 中结果是:640 480 3 30 = 27,648,000 字节每秒,即每秒超过 26 兆字节,这显然是不行的,尤其是网络传输带宽。

解决方案之一是使用某些库来实现视频编码。从本文标题可以猜到,我们的选择落在了 GStreamer 框架上。为什么是这个特殊的库?

下面是它与其他解决方案相比的一些优势:

良好的跨平台解决方案,支持Linux和Android。在RDK上,Gstreamer是包含在默认发行版中的编码/解码标准。它支持各种模块、过滤器和编解码器。例如,可以用于相同目的的FFmpeg(领先的多媒体框架)是GStreamer的模块之一。易于建立管道。创建编码/解码链很容易,且管道方法可以平滑替换编解码器、过滤器等,而无需重写代码。包含C / C ++ API。支持硬件编码器/解码器,尤其是OpenMAX API–与机顶盒配合使用的重要功能。探索GStreamer和管道

在进行代码测评之前,让我们看看没有它我们可以做什么。GStreamer包含了一些实用程序,尤其是:

gst-inspect-1.0将允许你查看可用编解码器和模块的列表,因此你可以立即查看将对其执行的操作并选择一组过滤器和编解码器。gst-launch-1.0允许你启动任何管道。GStreamer使用一种解码方案,其中数据流从源到接收器依次输出通过不同的组件。您可以选择任何东西作为源:文件、设备、输出(接收器)也可以是文件、屏幕、网络输出和协议(如RTP)。

播放mp4文件的经典示例:

前往“CNX Software中文站”官网,查看完整信息

输入接受mp4文件,该文件首先经过mp4 demuxer – qtdemux,然后通过h264解析器,而后经过解码器和转换器,最后是输出。

可以使用带有file参数的filesink替换autovideosink并将解码后的流直接输出到该文件。

使用GStreamer C / C ++ API编写应用程序。让我们尝试解码当知晓如何使用gst-launch-1.0时,我们将在应用程序中执行相同的操作。原理保持不变:我们正在构建解码管道,但现在正使用GStreamer库和glib-events。

我们将考虑一个H264解码的实时示例。

对GStreamer应用程序进行一次初始化

前往“CNX Software中文站”官网,查看完整信息

如果想要详细了解发生了什么,你可以在初始化之前设置日志记录级别。

前往“CNX Software中文站”官网,查看完整信息

注意:无论你的应用程序中有多少个管道,初始化一次gst_init就足够了。

让我们创建一个新的事件循环来处理事件:

前往“CNX Software中文站”官网,查看完整信息

现在我们可以开始构建管道了:将必要的元素(特别是管道本身)命名为GstElement类型。

前往“CNX Software中文站”官网,查看完整信息

管道的每个元素都是通过gst_element_factory_make创建的,其中第一个参数是类型,第二个参数是其GStreamer的条件名称,稍后它将依赖于这个名称(例如,在发出错误时)。

检查是否找到了所有组件,否则gst_element_factory_make返回NULL。

前往“CNX Software中文站”官网,查看完整信息

我们通过g_object_set设置相同的位置参数:

前往“CNX Software中文站”官网,查看完整信息

其他元素中的参数可以用相同的方式设置。

现在我们需要GStreamer消息处理程序,让我们创建相应的bus_call:

前往“CNX Software中文站”官网,查看完整信息

需要gst_object_unref和其他类似调用才能清除选定的对象。

然后,我们将命名消息处理程序本身:

前往“CNX Software中文站”官网,查看完整信息

现在最重要的是:我们将所有创建的元素收集并添加到单个管道中,该管道是通过gst-launch构建。当然,添加顺序很重要:

前往“CNX Software中文站”官网,查看完整信息

我们还应该注意,这种元素链接对于流输出非常有效,但在回放(autovideosink)的情况下,需要额外的同步demuxer(视音频分离器)和解析器的动态链接:

前往“CNX Software中文站”官网,查看完整信息

最后,让我们将传送状态转换为回放:与静态连接相比,动态连接可以确定线程的类型和数量,并且在需要时可以在某些情况下工作。

前往“CNX Software中文站”官网,查看完整信息

让我们运行事件循环:

前往“CNX Software中文站”官网,查看完整信息

完成此过程后,需要清理所有内容:

前往“CNX Software中文站”官网,查看完整信息

选择编码器和解码器。Fallbacks(回退函数)。在文档中还有很多有用的但几乎未提及的内容:如何轻松组织回退解码器或编码器。

gst_element_factory_find 函数将通过检查元素工厂中是否有编解码器来帮助我们完成此任务:

前往“CNX Software中文站”官网,查看完整信息

在此示例中,我们优先选择了RDK平台上的OMX硬件解码器,如果没有,我们将选择软件实现。

另一个非常有用但很少使用的功能是检查我们在GstElement中实际初始化的内容(许多编解码器中的哪一个):

前往“CNX Software中文站”官网,查看完整信息

你可以通过一种简单的方法来完成此操作,然后返回初始化的编解码器的名称。

视频色彩模型鉴于我们正谈论对来自摄像机的视频进行编码,所以颜色模型成为了绕不开的话题。这便是YUV(一种颜色编码方法)出现在舞台上的时候(比RGB频繁得多)。

相机只是喜欢YUYV色彩模型。但是GStreamer更喜欢与普通的I420机型协同工作。如果不是要在gl帧中输出,我们还将拥有I420帧。准备好设置您需要的过滤器并执行转换。

一些编码器也可以与其他颜色模型一起使用,但是更多情况下,这些是该规则的例外。

我们还应该注意,GStreamer有其自己的模块,用于从您的摄像机接收视频流,它可以用于构建管道,但我们将在其他时间再讨论它。

让我们处理缓冲区并即时获取数据。

输入缓冲区截至目前,我们仅通过filesrc对该文件中的内容进行了编码,并将所有内容显示在同一fileink或屏幕上。因此是时候处理数据流了。

现在,我们将使用缓冲区以及appsrc / appsink的输入和输出。由于某种原因,官方文档中几乎没有考虑到此问题。

那么,如何在创建的管道中组织恒定的数据流,或者确切地说,如何获得一个编码或解码的输出缓冲区呢?

假设我们从相机中获取了图像,且需对其进行编码。我们已经决定需要一个I420格式的框架。假设我们拥有它,下一步是什么?如何在整个管道流程中传递图片?

首先,让我们设置need-data事件处理程序,它将在需要向管道提供数据并开始向输入缓冲区提供数据时启动:

前往“CNX Software中文站”官网,查看完整信息

处理程序本身具有以下形式:

前往“CNX Software中文站”官网,查看完整信息

你可能会说“图像”是I420中图像缓冲区的伪代码。

接下来,我们通过gst_buffer_new_allocate创建一个所需大小的缓冲区,它将对应于图像缓冲区的大小。

使用gst_buffer_map,我们将缓冲区设置为写入模式并使用memcpy将映像复制到创建的缓冲区。

最后,我们向GStream发出信号,表示缓冲区已准备就绪。

注意:写入后必须使用gst_buffer_unmap,并在使用gst_buffer_unref之后清除缓冲区。否则,将发生内存泄漏。在可用示例数量很少的情况下,没有人特别关注内存使用情况,尽管这非常重要。

当我们处理完处理程序后,要做的另一件事是在接收到预期格式的接收时配置上限。

这是在安装需求数据信号处理程序之前完成的:

前往“CNX Software中文站”官网,查看完整信息

像所有GstElement参数一样,这些参数是通过g_object_set设置的。

在这种情况下,我们定义了流类型及其上限—数据格式,并指定appsrc输出将接收640×480分辨率和每秒30帧的I420数据。

对我们而言,频率通常不起作用。在工作时,我们没有注意到GStreamer以某种方式通过频率限制了需求数据的调用。

完成后,现在我们的帧被送入编码器。

输出缓冲区现在,让我们了解如何获取编码的输出流。

我们将处理程序连接到接收垫(sink pad):

前往“CNX Software中文站”官网,查看完整信息

同样,我们连接到另一个接收器事件GST_PAD_PROBE_TYPE_BUFFER,它将在数据缓冲区进入接收垫时触发。

前往“CNX Software中文站”官网,查看完整信息

回调函数具有类似的结构。现在,我们需要到达缓冲存储器。

首先,我们获取GstBuffer;然后,通过索引0使用gst_buffer_get_memory获取其内存的指针(通常,它是唯一涉及的指针);最后,使用gst_memory_map获得数据缓冲区地址bufInfo.data及其大小bufInfo.size。

事实上,我们已经实现了获得具有编码数据及其大小的缓冲区的目标。因此,我们回顾了用于智能电视和机顶盒的类似Zoom的视频会议应用程序的关键和最令人兴奋的组件:架构、带有GStreamer的编码/解码模块、输入/输出缓冲区以及所使用的颜色转换。

对数字电视运营商而言,这样的软件平台可以成为新的订户服务。对工程师来说,这是一个用于实现基于RDK、Linux和Android的不同机顶盒的有趣新嵌入式项目。对其他人来说,这是一个可以在COVID-19隔离或远程办公期间花时间在一起看电影和体育比赛、做运动以及与亲人见面的机会。

无论是在工程解决方案还是业务场景方面,这种在智能电视上使用视频会议服务的想法都可以得到进一步发展。因此,请随时在下面的评论中分享你的想法。

更多干货,请点击:CNX SOFTWARE中文站 — 嵌入式开发者的知识库!