各位网友好,小编关注的话题,就是关于scrapy爬取友情链接的问题,为大家整理了3个问题scrapy爬取友情链接的解答内容来自网络整理。

python如何爬取B站评论信息

这里简单介绍一下吧,B站的评论信息是动态加载的,存储在一个json文件中,只要抓包分析,提取到这个json文件,就能爬取到我们需要的评论信息,下面我简单介绍一下实现过程,实验环境win10+python3.6+pycharm5.0,主要内容如下:

这里为了更好的说明问题,以抓取B站https://www.bilibili.com/video/av1238716的评论信息为例(其他页面评论信息也行),如下:

1.首先,按F12调出开发者工具,依次点击“网络”->“所有”,刷新页面,如下,所有的抓包信息便会显示出来:

仔细分析,我们就会发现reply这个文件比较大,而且还是json的,很可能就是评论信息,点击进去,果然,就是我们需要爬取的评论信息,如下:

2.接着,针对上面的json文件,我们就可以编写对应的代码来进行解析了,主要用到requests和json这2个包,requests主要用于根据url请求json文件,json主要用于解析json文件,提取出我们需要的信息,主要代码如下:

程序运行截图如下,已经成功爬取到评论信息:

3.最后,就是保存我们爬取的评论信息了,代码如下,很简单,主要用到xlwt这个包,专门用于写入数据到excel中:

程序运行截图如下,已经成功保存信息到excel中:

至此,我们就完成了利用python来爬取B站评论信息。总的来说,这个过程很简单,就是抓包分析获取到json,然后解析json提取出我们需要的数据就行,只要你有一定的python基础,会简单的抓包分析,熟悉一下相关示例和代码,很快就能掌握的,当然,你也可以使用scrapy框架来爬取数据,都可以,网上也有相关教程和资料,感兴趣的可以搜一下,希望以上分享的内容能对你有所帮助吧,也欢迎大家评论、留言。

爬虫班是什么

爬虫班是指教授爬虫技术的培训班或课程。爬虫是一种自动化程序,可以模拟人的行为来浏览和提取网络上的信息。爬虫班的主要目的是教授学员如何使用编程语言(如Python)和相关工具(如Scrapy)来编写爬虫程序,以从网页或其他在线资源中收集和提取数据。通过学习爬虫技术,学员可以了解并掌握数据爬取、数据清洗和数据分析等技能,这对于进行数据科学、市场调研、舆情监测等领域的工作非常有用。

如何用python爬取网站数据

谢邀!这篇文章是小编看到的一篇实践型文章,《用Python爬取某东商品信息并可视化》,纯属搬运分享。

对于Ajax加载的网页已经分析了好几回,这回来说说利用selenium自动化获取网页信息。

通常对于异步加载的网页,我们需要查找网页的真正请求,并且去构造请求参数,最后才能得到真正的请求网址。而利用selenium通过模拟浏览器操作,则无需去考虑那么多,做到可见即可爬。

当然带来便捷的同时,也有着不利,比如说时间上会有所增加,效率降低。可是对于业余爬虫而言,更快的爬取,并不是那么的重要。

首先在电脑的PyCharm上安装selenium,然后下载与电脑上谷歌浏览器相对应版本的ChromeDriver。由于我的Mac系统版本较新,需要先关闭Rootless内核保护机制,才能够安装,所以也是折腾一番后才成功安装。

针对京东商城笔记本的网页进行分析,这回只要在网页源码上分析,就可以获取笔记本价格、标题、评论数、商家名称、商家性质。

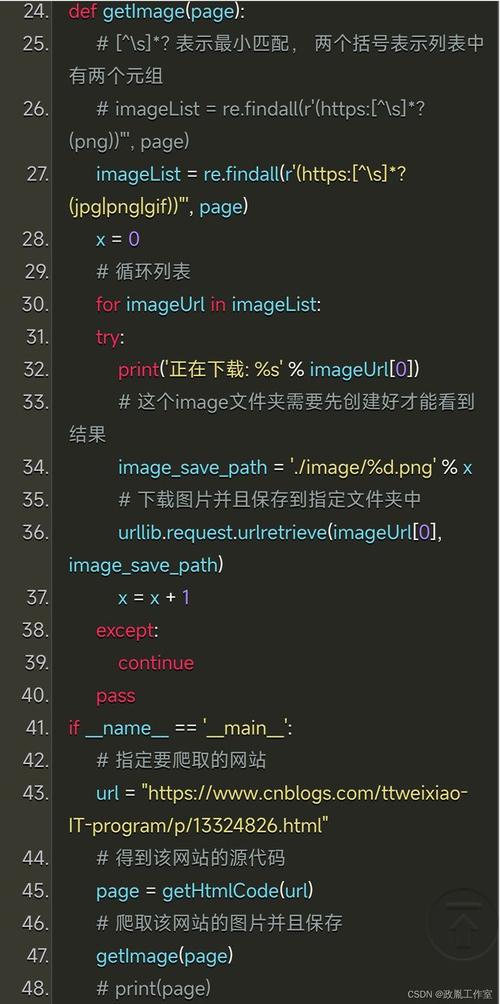

爬取代码如下:

虽然一开始就是以笔记本这个关键词去搜索,但是这里还是需要再点击一次笔记本按钮,这是因为直接搜索笔记本会出现平常上课做笔记的那种笔记本,导致会获取无用信息。所以利用京东自身更加详细的归类,得到我们想要的信息。

其中每一个网页有60条商品数据,那么按道理应该有6000条的笔记本商品信息,但是最后却只获取了5992条。

估计两个原因:

1⃣️在MongoDB中商品的标题为主键,商品标题出现重复

2⃣️网页未能加载完所有的商品信息

最后成功获取商品信息

读取MongoDB中数据进行可视化分析

从上面可以看出,ThinkPad位居榜首,也与后面的词云图有所呼应。商务、办公,因为它就是一款以商务办公为主打品牌的笔记本。此外国内品牌联想、华硕、宏碁、华为也在榜上,支持国货!!!

笔记本价格区间在4000-6000有较大的集中,也一定程度反应出了现在笔记本的中间价位,记得刚上大学那会,价格在5000+的笔记本就能有着不错的配置,LOL特效全开。

统计下来自营与非自营,还是小巫见大巫。京东和淘宝最大的区别就是京东有自营产品,送货也快。虽说自营的也有假货,但是还是小概率事件。购买电子产品时,比如手机、电脑等,对于我这种小白而言,我第一选择就是去官网或者京东自营店购买,我是绝对不会去电子城和奸商们斗智斗勇的,即使可能价格会低点。但是官网一般快递比较慢,需要个3-5天,而京东可能只需1-2天,所以京东算是我购买的最优选择。

这里把标题中笔记本配置参数全部用正则筛选掉。虽说笔记本参数决定了笔记本的性能,不过真正的去购买一台笔记本时,最重要的还是根据自己的需求和预算,然后再去考虑笔记本参数,最后选择一部适合自己的笔记本。一般的笔记本参数如下:

CPU:酷睿系列i3、i5、i7,标压M与低压U

硬盘:500G、1T、2T

显卡:AMD,NVIDIA

内存:4G,8G

作者:张凡幸 来源:https://mp.weixin.qq.com/s/VaUfaU6_u_PTV5XaEPNngA

这里简单介绍一下吧,以抓取网站静态、动态2种数据为例,实验环境win10+python3.6+pycharm5.0,主要内容如下:

抓取网站静态数据(数据在网页源码中):以糗事百科网站数据为例

1.这里假设我们抓取的数据如下,主要包括用户昵称、内容、好笑数和评论数这4个字段,如下:

对应的网页源码如下,包含我们所需要的数据:

2.对应网页结构,主要代码如下,很简单,主要用到requests+BeautifulSoup,其中requests用于请求页面,BeautifulSoup用于解析页面:

程序运行截图如下,已经成功爬取到数据:

抓取网站动态数据(数据不在网页源码中,json等文件中):以人人贷网站数据为例

1.这里假设我们爬取的是债券数据,主要包括年利率、借款标题、期限、金额和进度这5个字段信息,截图如下:

打开网页源码中,可以发现数据不在网页源码中,按F12抓包分析时,才发现在一个json文件中,如下:

2.获取到json文件的url后,我们就可以爬取对应数据了,这里使用的包与上面类似,因为是json文件,所以还用了json这个包(解析json),主要内容如下:

程序运行截图如下,已经成功抓取到数据:

至此,这里就介绍完了这2种数据的抓取,包括静态数据和动态数据。总的来说,这2个示例不难,都是入门级别的爬虫,网页结构也比较简单,最重要的还是要会进行抓包分析,对页面进行分析提取,后期熟悉后,可以借助scrapy这个框架进行数据的爬取,可以更方便一些,效率更高,当然,如果爬取的页面比较复杂,像验证码、加密等,这时候就需要认真分析了,网上也有一些教程可供参考,感兴趣的可以搜一下,希望以上分享的内容能对你有所帮助吧。

到此,大家对scrapy爬取友情链接的解答时否满意,希望scrapy爬取友情链接的3解答对大家有用,如内容不符合请联系小编修改。